- Les « hallucinations de l’IA » sont un terme collectif pour désigner les mensonges, les évasions et les préjugés.

- Le copilote montre ses défauts aux chercheurs.

- Trois raisons de ne pas investir dans l’IA pour votre organisation

Il est connu et compris depuis l’aube de ChatGPT que les « hallucinations de l’IA » constituaient un risque pour l’utilisation de modèles d’IA génératifs. La capacité de présenter en toute confiance des informations parfois inexactes comme des faits irréprochables a été l’une des premières raisons pour lesquelles les analystes ont mis en garde contre une confiance aveugle dans ce que des modèles comme ChatGPT, Bard et Bing Chat vous ont dit, où leur main électronique sur leur GPU était la vérité évangélique.

Aujourd’hui, des chercheurs indépendants ont mesuré la qualité des réponses fournies par Copilot de Microsoft (anciennement Bing Chat) et ont constaté que dans un nombre important de cas, ses réponses étaient factuellement incorrectes, évasives ou montraient un parti pris politique. Un an après le lancement de ChatGPT, l’hallucination de l’IA est toujours vivace, menaçant de fausser les projets auxquels sont appliqués des modèles génératifs pionniers.

Organisations indépendantes Forensique d’intelligence artificielle Et AlgorithmeWatch (Site multilingue ici3 515 demandes adressées à Microsoft Copilot concernant deux élections récentes en Suisse et en Bavière, en Allemagne, avec des réponses jugées contenant des « erreurs factuelles », « une évasion », « tout à fait exactes » et « souffrant de déséquilibre politique ». Le groupe a également noté que les sources d’informations publiées en ligne en anglais semblaient être privilégiées par Copilot, par opposition à celles en langues locales (allemand, français, italien).

le rapport, Disponible ici [pdf], a montré qu’un tiers (31 %) des réponses aux requêtes d’un algorithme d’apprentissage automatique contenaient des erreurs factuelles, tandis que 40 % d’entre elles étaient classées comme « évasives ». Ces dernières incluent des réponses qui discutent, par exemple, des élections en général plutôt que de répondre par des réponses politiquement pondérées. « Le robot indique parfois clairement qu’il doit rester politiquement neutre dans ses réponses, par exemple lorsqu’on lui demande pour qui il voterait lors de la recherche d’un candidat favorable à la réduction des coûts d’assurance », indique le journal.

Intelligence artificielle avec un sens de l’humour.

#L’intelligence artificielle #ai #Apprentissage automatique #GémeauxAI pic.twitter.com/zdERGbL29m-Noman (@nfntweets) 11 décembre 2023

Hallucinations de l’IA, ou simplement une approche grossière pour permettre à l’IA générative de renvoyer des réponses complètement réalistes ? Le rapport conclut, à partir des réponses reçues, que cette fraude résulte des garanties que Microsoft avait intégrées à son logiciel Copilot pour contrecarrer les préjugés. Toutefois, les chercheurs ont constaté que ces garanties étaient tout aussi efficaces S’applique inégalement – ce qui rend effectivement cela absurde dans l’application.

Interrogé sur des allégations controversées liées à des candidats spécifiques à l’élection, Copilot a déclaré qu’il n’était pas en mesure de trouver d’informations ou, dans un cas, Inventer des affirmations sur le candidat.

Dans le langage courant, les réponses d’un copilote qui pourraient être qualifiées d’évasion, de mauvaise réponse ou de parti pris politique sont appelées « hallucinations », un terme qui fait référence à une envolée si hors des sentiers battus qu’elle peut être immédiatement reconnaissable comme telle et écarté par le lecteur. Cependant, sans aucune indication que l’algorithme soit susceptible d’être précis dans ses réponses, la frontière entre hallucination et mensonge pur et simple est sujette à débat.

L’hallucination de l’IA s’est effondrée. Source : AI Forensics et AlgorithmWatch

AI Hallucination – Accédez à une application près de chez vous

Plusieurs grandes plateformes technologiques ont récemment annoncé des produits nouveaux ou émergents qui répondront aux questions sur les données stockées par l’entreprise afin que les entreprises puissent visualiser les informations plus facilement. Les recherches d’AI Forensics et d’AlgorithmWatch montrent que de tels systèmes peuvent être profondément défectueux. Prendre des décisions critiques sur des informations dont 31 % des réponses contiennent des erreurs factuelles n’est pas une bonne pratique – et ne serait sans doute pas tolérée par des organisations sérieuses si elles n’étaient pas encapsulées dans la technologie. Du jour Il s’agit de l’intelligence artificielle générative.

De plus, si les données collectées contiennent un contenu multilingue ou si les requêtes posées portent sur des problématiques personnelles (« Qui est le meilleur chef d’équipe ? »), les organisations peuvent se retrouver induites en erreur.

Il y a beaucoup de choses intéressantes à apprendre d’un document de recherche. La première est que les algorithmes d’apprentissage automatique représentent Couche d’abstraction Entre données brutes et découverte. Les utilisateurs de ce que l’on appelle les plateformes d’IA ne peuvent, par défaut, pas se référer aux documents originaux à partir desquels les réponses de l’IA sont tirées. Cela élimine l’évaluation humaine de l’authenticité d’une source, un processus qui repose sur plusieurs signaux, tels que le style de la langue source, l’auteur, le contexte, la période et une foule d’autres facteurs.

Ce niveau plus profond de recherche, de compréhension et de formation d’opinions prend du temps et de l’énergie, et constitue un problème qu’un chatbot facile à utiliser propose de résoudre. Mais si les réponses aux questions sont incorrectes (ou « hallucination de l’IA »), le temps gagné peut facilement être annulé par les effets des décisions basées sur les réponses.

Le deuxième problème est Opacité. En l’absence d’indication de probabilité statistique de vérité, la validité et la fiabilité de chaque réponse sont égales. Une requête telle que « Quel vendeur a généré le plus de revenus ce trimestre ? » On peut probablement y répondre avec une probabilité de précision de 99 %. Mais « tout vendeur a Meilleure performance Ce trimestre ? » pourrait donner la même réponse, mais la réponse est complètement fausse sans une explication contextuelle de la réponse et une indication de la probabilité que la réponse soit correcte – ou de la manière dont la réponse a été obtenue.

Montrez votre travail, comme on l’a dit à un moment ou à un autre à chaque étudiant en mathématiques frustré.

AI – 100% A, pas particulièrement moi

Le troisième problème est le suivant : Utilisation abusive du terme « intelligence artificielle » – Un problème endémique dans ce domaine. Les réponses du chatbot IA sont basées sur la probabilité syntaxique. Cela signifie que les réponses sont interprétées en fonction de la probabilité probable qu’un mot se succède (avec une pincée de sel ajoutée pour garantir des résultats apparemment aléatoires). Le « grand modèle de langage » plus communément décrit n’est pas utilisé à la place de l’intelligence artificielle. C’est dommage, car le LLM, plus descriptif, donne aux utilisateurs une idée des limites inhérentes à l’outil. Les réponses « IA » ne sont pas générées à la volée par une intelligence qui mesure la validité de ses données et modère la réponse en fonction de la perception de ce que veut la personne qui pose la question.

Pour utiliser une analogie qui simplifie dans une large mesure les LLM dans les contextes commerciaux : le LLM utilise les données sur lesquelles il a été formé pour créer des phrases basées sur la probabilité d’un mot. C Mot suivant B Mot suivant une. Par exemple, s’il y a un biais dans les données en faveur de l’utilisation du mot B, apparaîtra davantage. Cela peut contredire les meilleurs résultats dont le questionneur a besoin, mais comme il existe une couche d’abstraction entre la source (les données) et sa présentation (la réponse donnée), un biais ou une inexactitude au niveau inférieur ne se produit jamais.

Législation, sous la forme de l’Union européenne Loi sur les services numériques (2022), Il stipule que les grandes entreprises doivent atténuer les risques posés par leurs services. Dans le cas de grands modèles de langage, ces risques, affectueusement appelés « hallucinations de l’IA », sont protégés par l’utilisation de garde-fous de code au sein d’algorithmes obscurcis. Selon les chercheurs, même en garantissant de meilleures protections, cela ne résoudra pas les problèmes qui font de l’IA dans des contextes critiques un simple collecteur de données, même s’il est capable de prononcer des phrases polies.

Responsabilité de l’acheteur. Et dors bien…

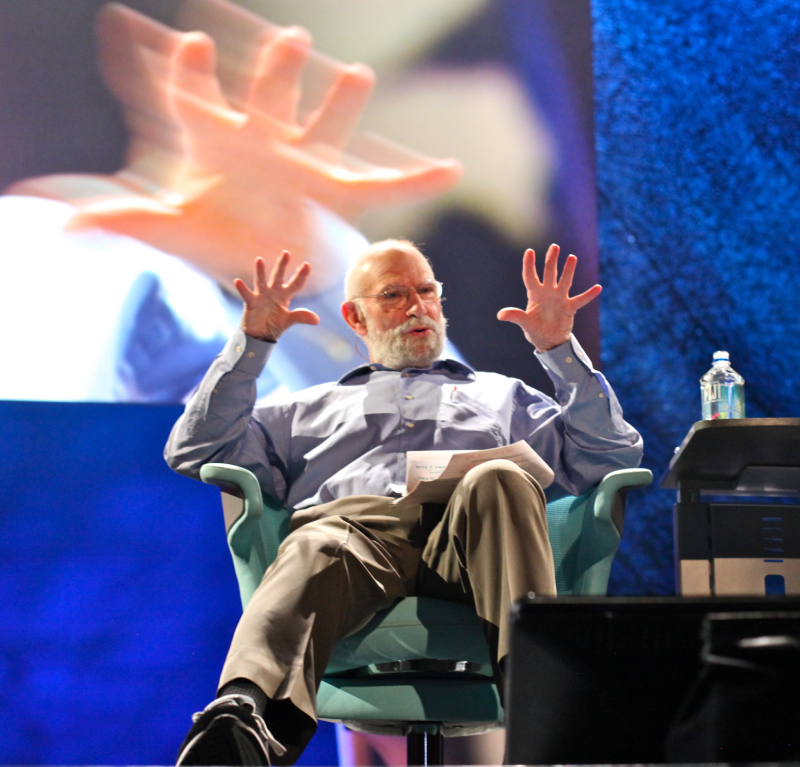

Oliver Sacks, neurologue, est spécialisé dans les hallucinations du cerveau humain.

« Évangéliste amateur de zombies. Créateur incurable. Fier pionnier de Twitter. Amateur de nourriture. Internetaholic. Introverti hardcore. »

More Stories

Les initiés affirment que la mise à niveau de pointe de l’IA sera lancée d’ici quelques jours

Revue Switch d'El Shaddai : superficielle, prétentieuse et maladroite

Un nouveau jeu « Fallout » à venir ?