Nvidia et Microsoft ont annoncé leur plus grand modèle de langage de transformateur monolithique à ce jour, un modèle d’intelligence artificielle avec 530 milliards de paramètres qu’ils ont développé ensemble, surnommé le modèle Megatron-Turing Natural Language Generation.

Le MT-NLG est plus puissant que les précédents systèmes basés sur un commutateur que les deux sociétés ont formés, à savoir le modèle Turing-NLG de Microsoft et le Megatron-LM de Nvidia. MT-NLG se compose de trois fois les paramètres répartis sur 105 couches, et est beaucoup plus grand et plus complexe. A titre de comparaison, OpenAI Modèle GPT-3 175 milliards d’enseignants et Google adaptateur de commutateur La démo contient 1,6 billion de paramètres.

Plus gros est généralement mieux quand il s’agit de réseaux de neurones. Cela les oblige à absorber plus de données d’entraînement. MT-NLG est meilleur dans une variété de tâches en langage naturel telles que les phrases à saisie semi-automatique, les questions et réponses, la lecture et l’inférence que ses prédécesseurs. Il peut également effectuer ces tâches avec peu ou pas de réglage fin, ce que l’on appelle l’apprentissage à faible dose ou l’apprentissage sans prise de vue.

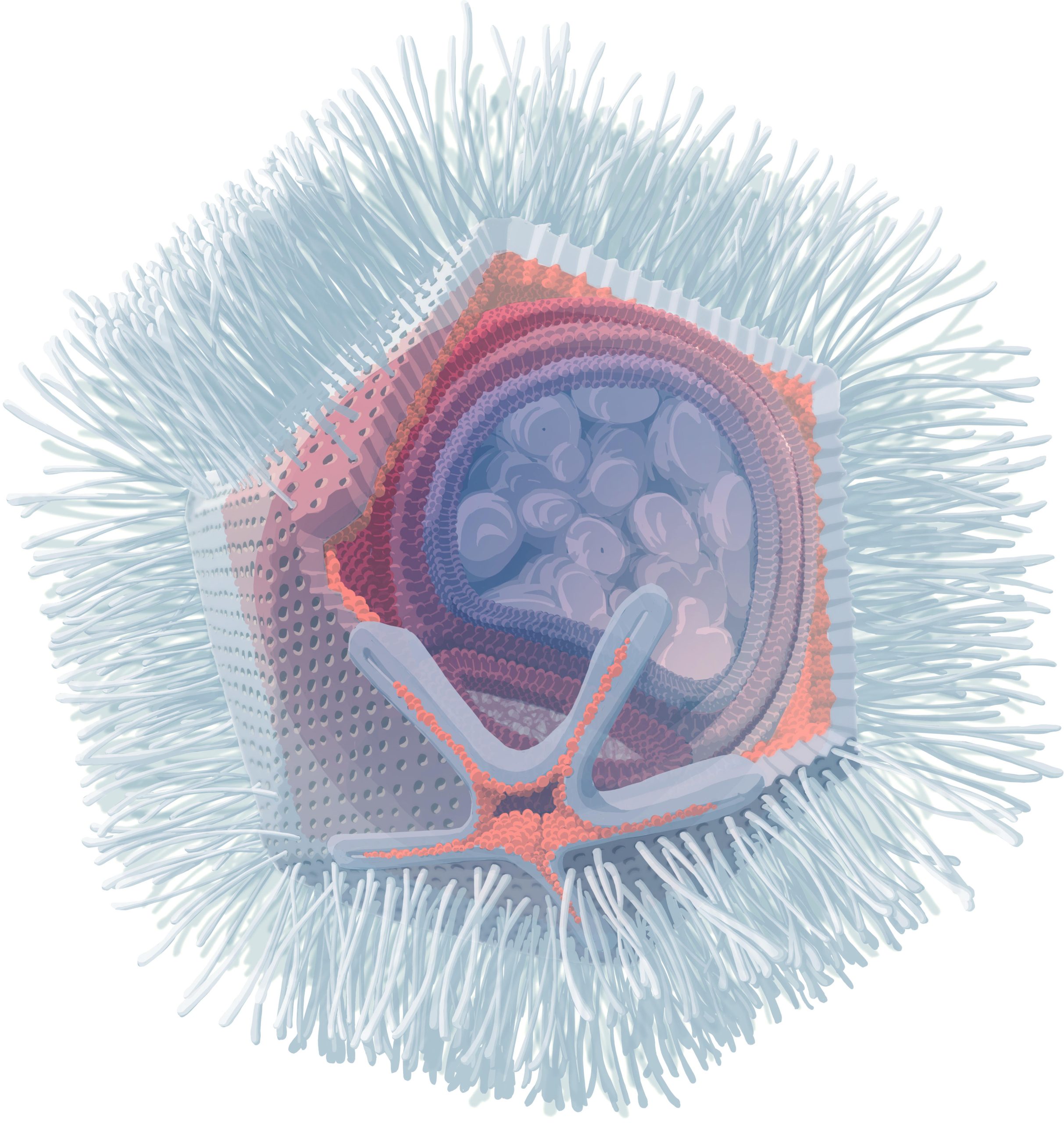

À mesure que ces modèles de langage grandissent, les chercheurs et les ingénieurs en IA doivent concevoir toutes sortes de techniques et d’astuces pour les former. Cela nécessite un formatage précis : le modèle et ses données d’apprentissage doivent être stockés et traités sur plusieurs puces en même temps.

Le MLT-NLG a été formé à l’aide du superordinateur d’apprentissage automatique Selene de Nvidia, un système composé de 560 serveurs DGX A100, chaque serveur contenant huit GPU A100 de 80 Go. Selene est également alimenté par le processeur EPYC 7v742 d’AMD et son coût est estimé à plus de 85 millions de dollars. selon à la plate-forme suivante.

Les 4 480 GPU utilisent NvLink et NVSwitch pour communiquer entre eux. Chacun était capable de fonctionner à plus de 113 téraflops par seconde. Ces modèles sont incroyablement coûteux à former, et même s’ils fonctionnent sur du matériel haut de gamme, ils nécessitent des hacks logiciels pour réduire les temps de formation. Utiliser Nvidia et Microsoft Vitesse profonde, une bibliothèque d’apprentissage en profondeur contenant du code PyTorch qui a permis aux ingénieurs de rassembler davantage de données via de nombreux pipelines en parallèle.

« من خلال الجمع بين التقطيع الموتر والتوازي مع خطوط الأنابيب ، يمكننا تشغيلهما ضمن النظام حيث يكونان أكثر فاعلية » ، هكذا قال باريش خاريا ، المدير الأول لإدارة المنتجات والتسويق للحوسبة المتسارعة في NVIDIA ، وعلي ألفي ، مدير برنامج المجموعة في Microsoft فريق تورينج ، موضح في une Article de blog.

Plus précisément, le système utilise le découpage tensoriel de Megatron-LM pour mettre à l’échelle le modèle au sein d’un nœud et utilise le parallélisme de pipeline de DeepSpeed pour mettre à l’échelle le modèle sur les nœuds.

Par exemple, pour le modèle de 530 milliards, chaque réplique couvre 280 GPU NVIDIA A100, avec un tenseur à 8 voies à l’intérieur d’un nœud et un parallélisme de pipeline à 35 voies entre les nœuds.Nous utilisons ensuite le parallélisme des données de DeepSpeed pour le faire évoluer à des milliers d’unités de traitement graphique.

MT-NLG a été formé sur un ensemble de données géant connu sous le nom de pile. Compilé par Eleuther AI, un groupe de chercheurs et d’ingénieurs en intelligence artificielle à la tête d’un effort de base pour de grands modèles de langage open source, il est composé de plusieurs ensembles de données plus petits totalisant 825 gigaoctets de texte tiré d’Internet à partir de sources telles que Wikipédia et des référentiels Revues universitaires , extraits d’actualités.

Traiter de si grandes quantités de texte signifie qu’un ensemble de données ne peut pas être nettoyé d’un langage toxique. Malheureusement, cela signifie que MT-NLG peut générer des résultats offensants qui peuvent être racistes ou sexistes.

« Notre observation avec MT-NLG est que le modèle capte les stéréotypes et les biais des données en cours de formation », ont déclaré Kharya et Alvi.

Microsoft et NVIDIA se sont engagés à travailler pour résoudre ce problème. Nous encourageons la poursuite des recherches pour aider à déterminer l’étendue du biais du modèle… De plus, toute utilisation de MT-NLG dans des scénarios de production doit garantir que des mesures appropriées sont en place pour atténuer et minimiser les dommages potentiels aux utilisateurs.

« Évangéliste amateur de zombies. Créateur incurable. Fier pionnier de Twitter. Amateur de nourriture. Internetaholic. Introverti hardcore. »

More Stories

La mise à jour Fallout 4 Next-Gen regorge de problèmes

Achetez deux chargeurs et câbles rapides Anker USB-C pour seulement 13 $ avec Amazon Prime

La BlizzCon saute 2024 au profit de plusieurs événements mondiaux pour présenter World of Warcraft, l'extension Diablo et bien plus encore.